AIの「脳」にも“腐敗”が起きる:研究結果

AIモデルは結局のところ、人間に少し似ているのかもしれない。

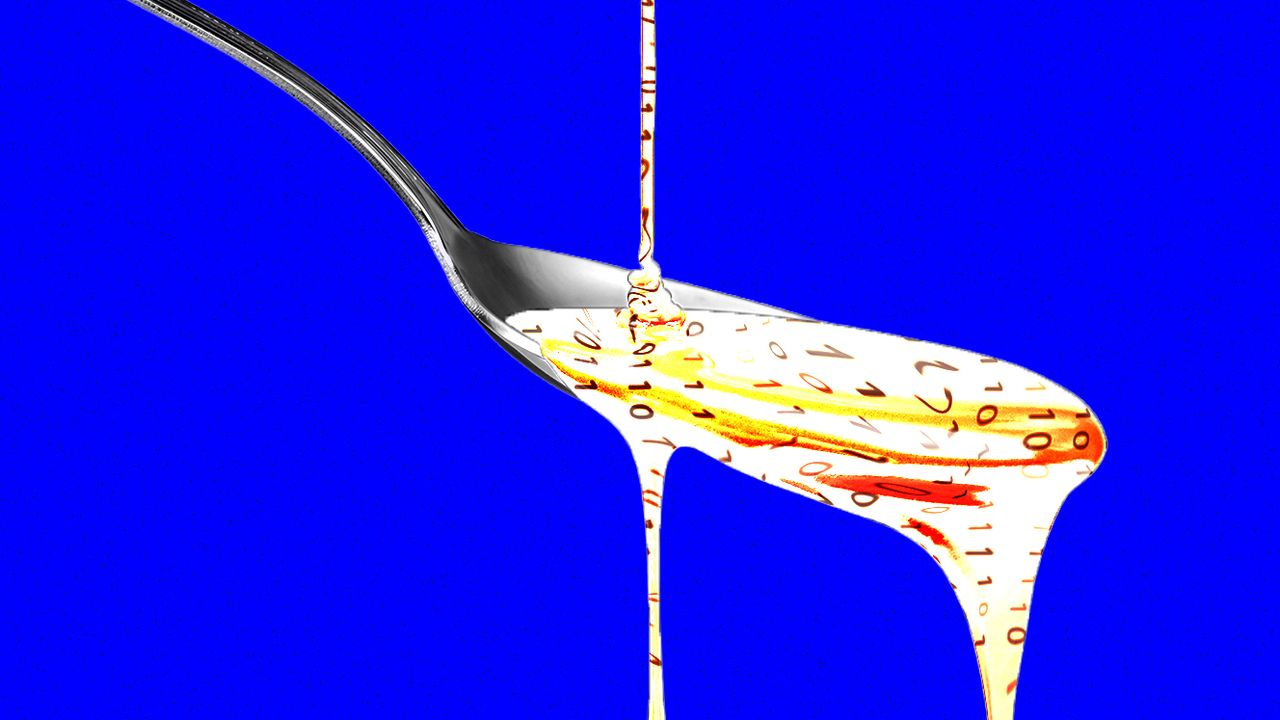

テキサス大学オースティン校、テキサスA&M大学、パデュー大学による新たな研究によると、ソーシャルメディア上では人気だが、実際には低品質なコンテンツを与えられた大規模言語モデル(LLM)には、「脳の腐敗」とも呼べるような認知面での劣化が起きるという。これは、XやTikTokを延々と見続けたことがある人なら、心当たりがあるかもしれない現象だ。

「わたしたちは、情報の量が注意力よりも速く増加する時代に生きています。そしてその多くは真実や深みよりもクリックを稼ぐためにつくられているのです」。こう語るのは、テキサス大学オースティン校の大学院生として研究に参加したジュンユエン・ホン(シンガポール国立大学助教授に着任予定)だ。「では、AIが同じものを与えられたらどうなるだろう? それを知りたいと思いました」

ホンらのチームは、ふたつのオープンソースのLLMに、異なる種類のテキストを与えて事前学習を行った。「wow(すごい)」「look(見て)」「today only(今日だけ)」など、大袈裟な表現を多く含む、いわゆる“エンゲージメントの高い”投稿を混ぜたデータで訓練したのだ。

実験に使われたのは、メタの「Llama」とアリババの「Qwen」というふたつのモデル。研究者たちは、複数のベンチマークを用いて、“ジャンクなSNS食”がモデルに与える影響を測定した。

ジャンクテキストを与えられたモデルは、AIなりの“脳の腐敗”を経験した。推論能力の低下や記憶力の低下といった認知機能の低下が見られたのだ。また、倫理的な整合性が弱まり、サイコパス的になる傾向も、ふたつの指標によって確認された。

これらの結果は、人間を対象とした研究とも一致している。低品質なオンラインコンテンツが人間の認知能力を損なうことはすでに知られており、2024年のオックスフォード英語辞典では「脳の腐敗(brain rot)」が今年の言葉に選ばれている。

この結果はAI業界にとって重要だとホンは言う。モデルを構築する開発者たちは、ソーシャルメディアの投稿が有用なトレーニングデータになると思い込んでいるかもしれないからだ。「バズる投稿や注目を集めるコンテンツで学習させると、データ量が増えていいと思えるかもしれません。でもそれは推論、倫理観、長文への注意力を蝕んでいくのです」とホンは警告する。

汚染されたデータが次世代AIを蝕む

さらに問題なのは、AI自身がSNS上で膨大なコンテンツを生成しており、その多くがエンゲージメント最適化を目的としている点だ。研究チームは、いったん低品質なデータで劣化したモデルは、後から再訓練しても簡単には回復しないことも確認した。

この発見は、ソーシャルプラットフォームと密接に結びついたAIシステム──例えば「Grok」など──にも影響が及ぶ可能性を示唆している。ユーザー投稿を品質検証なしに学習に使うと、性能や倫理性が損なわれるリスクがあるという。

「AIスロップ(AIが生成した低品質なコンテンツ)がソーシャルメディア上で拡散すればするほど、次世代のモデルが学習するデータそのものが汚染されていきます」とホンは言う。「このような 脳の腐敗が一旦起きると、その後のクリーンなデータで訓練しても完全に元に戻すことはできないのです」

(Originally published on wired.com, translated and edited by Mamiko Nakano)

※『WIRED』による人工知能(AI)の関連記事はこちら。

Related Articles

雑誌『WIRED』日本版 VOL.57「The Big Interview 未来を実装する者たち」発売中!

気鋭のAI研究者たちやユヴァル・ノア・ハラリが語る「人類とAGIの未来」。伝説のゲームクリエイター・小島秀夫や小説家・川上未映子の「創作にかける思い」。大阪・関西万博で壮大なビジョンを実現した建築家・藤本壮介やアーティストの落合陽一。ビル・ゲイツの回顧録。さらには不老不死を追い求める富豪のブライアン・ジョンソン、パリ五輪金メダリストのBガール・AMIまで──。未来をつくるヴォイスが、ここに。グローバルメディア『WIRED』が総力を結集し、世界を動かす“本音”を届ける人気シリーズ「The Big Interview」の決定版!!詳細はこちら。