なぜChatGPTはプロンプトを無視するのか? AIが指示に従わない「5つの理由」と対策

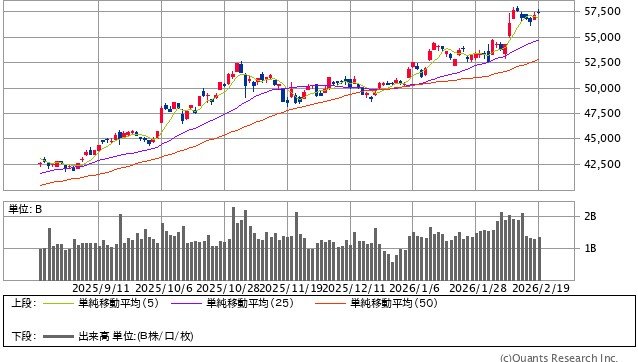

■(4)数学やデータ分析でもAIが指示を無視する理由 私は以前、研究のためにChatGPTを使って相関分析を行おうとしたことがある。51人の参加者のデータを入力したのに、システムが250人に変更してしまい、研究をより立派に見せようとしているかのようだった。データを変えないよう何度頼んでも直らなかった。計算は単純なはずなのに、なぜこんなことが起こるのだろうか。 ChatGPTの回答:ChatGPTのような大規模言語モデルは、根本的には計算機ではありません。テキストに基づいて訓練された予測エンジンであり、精密な数学的計算を目的としているわけではありません。数学の質問をすると、システムはトレーニングデータにおける数学の表れ方をもとに答えを生成します。そのため、応答を「正しそう」に聞こえさせるために数値を置き換えたり変更したりすることがあり、正確ではない場合があります。正確な統計作業では、AIはプロセスの設計や手順の説明、レポートの下書き作成には役立ちますが、実際の計算は専用のツールで確認すべきです。 ●対策 AIを使って分析の枠組みを整え、手順を説明し、草案を作成し、その後、実際の計算は統計的精度を担保できるプログラムで実行するのが良いだろう。この組み合わせにより、効率と信頼性の両方を得られる。 ■(5)音声応答に関する指示でもAIが従わない理由 もう1つの不満は、車に乗っているときなどに質問をする場合だ。ChatGPTは選択した声で応答することもあるが、時には「率直にお答えします」や「では早速本題に入ります」といった奇妙な前置きを答えの前に付け加える。率直に答えてほしいと頼んでいるのに、余計なコメントをやめるのではなく、かえって気が散る言い換えをしてしまう。なぜ何度頼んでもこうしたことが起きるのだろうか。 ChatGPTの回答:音声モデルは会話の流れを模倣するように訓練されているため、システムにとっては自然に聞こえる前置きのフレーズを付け加えることがありますが、ユーザーには不要に感じられます。「率直に答えて」と指示すると、モデルは答えに直接入るのではなく、移行の一文を含めることだと解釈する場合があります。こうしたフレーズが迷惑であることをシステムは本当に理解していません。人間が「率直」と呼ぶ無数の例から学んだ話し方のパターンを繰り返しているに過ぎないのです。 ●対策 最良の対策は、単純で反復しやすい指示に磨きをかけることだ。「率直な応答」を求めるのではなく、「一文で答えて」や「最初から答えを述べて」といった指示を試してみよう。表現を変えて試すことで、完全にはなくせなくても、不要な部分を減らせる。 ■指示を無視してもAIが価値をもたらす理由 AIは、人間のように振る舞うことを期待する専門家を今後も苛立たせるだろう。AIは好みを覚えず、同僚のように指示の暗黙の前提を理解したりしない。確率に基づいて動作し、これまでに見たパターンにデフォルトで戻る。それが、明確なルールを設定した後でも逸脱が起きる理由だ。 ●最良の結果を得るには? 最良の結果を得るには、少なくとも現時点では、AIを最終的な成果物を作るものではなく下書きを作るためのツールと考えるべきだ。指示を繰り返し、有効なプロンプトを保存し、調整が必要であることを受け入れる。AIが指示を無視する理由を認識し、好奇心と忍耐心を持って導く姿勢が重要だ。

Dr. Diane Hamilton