Googleのチート技術で「使えるスマホAI」が爆誕してた

今後に期待。

2025年5月20日にGoogleが「Gemma 3n」というAIモデルを発表しています。Gemma 3nはスマートフォンで動作するのが最大の特徴です。ChatGPTやGeminiなどとは異なり、ネット接続なしで使えるし、プライバシーが関わるインプットをしてもいいAIということです。

プレビュー版が公開されていたので実際どんな感じなのか試してみたのですが、既存の同タイプのAIモデルよりも格段に進化しており、驚きました。開発者向けにプレビュー公開というステータスなので、正式公開時には仕様や性能が変わる可能性がありますが、既存の同系統のAIから推論能力が格段にアップしており、正式公開が楽しみになりました。

モバイル用AIが突き当たっていた“壁”を破壊

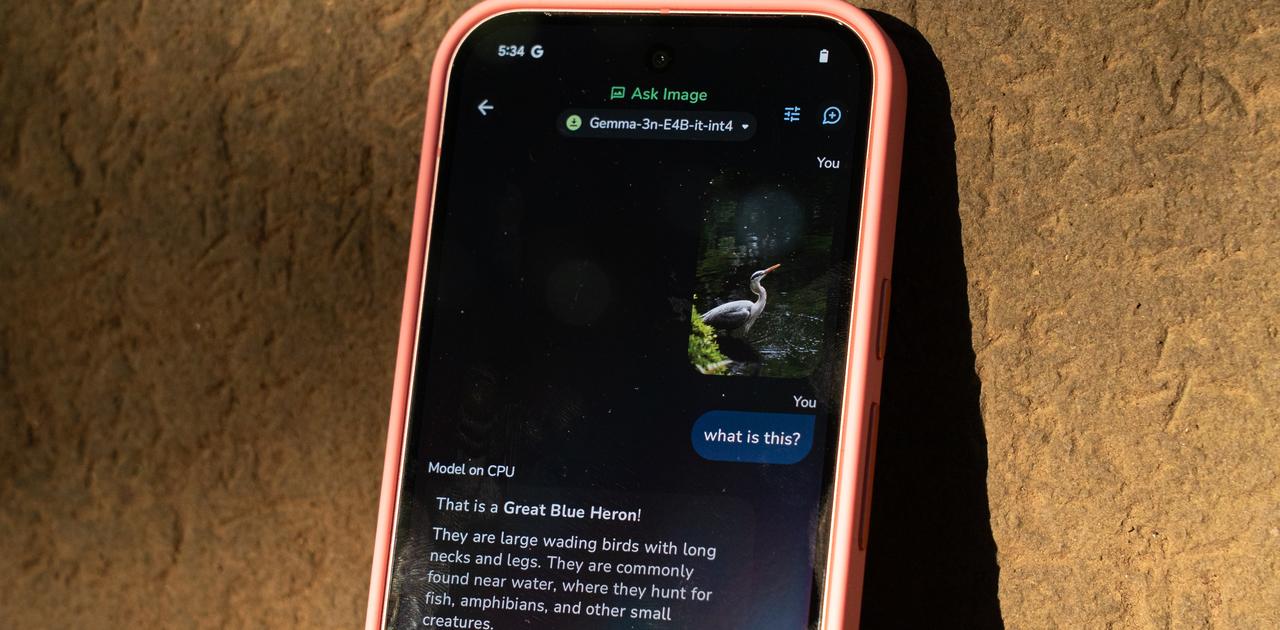

Gemma 3n・Gemma 3 1.5B Instruct・Qwen 2.5 1.5B Instructは、Google AI Edge Gallery内のデフォルト設定で試用しています。量子化についても同様ですGemma 3nは、回答の質がいい賢さ重視モデル「Gemma 3n E4B」と反応が速い高速軽量モデル「Gemma 3n E2B」の2モデル展開。Google AI Edge Galleryというアプリを入れてDLすれば試せます(詳しくは後述しますが、DL先やインストール方法が通常のアプリとは異なります)。今のところできるのは、チャットと画像認識です。

いろんなAIと翻訳勝負させてみた

Gemma 3n E4Bいろいろ試した中だと、以下のような「翻訳タスク」がGemma 3nの性能を感じやすかったです。

カジュアルなトーンで日本語に翻訳してください:

Foundation models are applied in a broad spectrum of settings with different inference constraints, from massive multi-accelerator clusters to resource-constrained standalone mobile devices. However, the substantial costs associated with training these models often limit the number of unique model sizes that can be offered. Consequently, practitioners are compelled to select a model that may not be optimally aligned with their specific latency and cost requirements.

Gemma 3n E4Bの翻訳

賢いほうのモデル「Gemma 3n E4B」の回答はこちら、なかなかわかりやすく訳せてませんか?(基礎モデルというのは、ざっくり「AI(大規模言語モデル)」と思ってもらってOKです)。

大規模なコンピューター集団から、スマホのような性能が限られたデバイスまで、色々な場所で基礎モデルが使われています。でも、これらのモデルを作るにはすごくお金がかかるので、提供できるモデルのサイズが限られてしまいます。そのため、使う人は、自分の作りたいものにぴったりのモデルを選ぶのが難しいんです。

(translated with Gemma 3n E4B)

参考:GPT o4-miniの翻訳

参考までに別のAIで訳した原文に忠実な“硬い翻訳”も載せておきます。比べると、Gemma 3n E4Bが要点を押さえつつ、柔らかく訳しているのが感じられるのではないかと思います。

ファウンデーションモデルは、巨大なマルチアクセラレータークラスターからリソース制約のあるスタンドアロンのモバイルデバイスまで、さまざまな推論制約の下で広範囲に適用されています。しかし、これらのモデルのトレーニングに関連するかなりのコストは、提供できるユニークなモデルサイズの数を制限することが多いです。その結果、実務者は特定のレイテンシーとコスト要件に最適に一致しないモデルを選択せざるを得なくなります。

(translated with OpenAI GPT o4-mini)

既存のスマホAIの翻訳

Qwen 2.5 1.5B Instructでも、これだけじゃ「まぁ訳せてるよね」止まりかもしれないですね。やはり「他と比べてどうか?」は欲しい。というわけで、既存のスマホで動くAI(2モデル)で同系統のプロンプトを試した結果も掲載します。

Foundation Modelsは幅åºĥい設定でさまざまな推論制限が適用され、from Massive Multi-Accelerator Cluster to Resource-Constrained Standalone Mobile Device.しかし、これらのモデルの学習コストが大きな影響を及ぼす場合、特定の推論éģħ延とコスト要件に合わせた最適なモデルを選æĬŀする必要がçĻº生します。

(translated with Qwen 1.5B-It)

<0xE3><0x80><0x80><0xE3><0x80><0x80>基盤モデルは、さまざまなインferenz的制約を抱える、ものがあり、多用途の高速化マルチアッセンブラートクラスタから、資源的で孤立したスタンドアロンモバイルデバイスまで、幅広い適用される可能性がある。"<0xE3><0x80><0x80><0xE3><0x80><0x80><0xE3><0x80><0x80><0xE3><0x80><0x80><0xE3><0x80><0x80><0xE3><0x80><0x80><0xE3><0x80><0x80>しかし、モデルを訓練するために、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、、

(translated with Google Gemma 3 1.5B-It)

Gemma 3n E4Bの何がすごいか。それは多言語対応がきちんとされており「日本語で質問してまともな回答がもらえる」に尽きます。

どうしても自分が試した範囲での体感になってしまうのですが、既存の小型モデルは日本語で多少高度な質問をすると、使えない回答をしてくる率が50-60%程度はあります。英語で回答してくることもありますし、今回のように崩壊しているケースも少なくありません。そのため、「小型モデルって実用はちょっと厳しいな…」と感じていましたが、Gemma 3nはこの印象を完全に破壊してくれました。

Gemma 3n E2Bの翻訳

Gemma 3n E2B推論性能を犠牲にする代わりにレスポンス速度を重視した「Gemma 3n E2B」もこういったレベルは完全に脱しています。

近年、大規模言語モデル(LLM)は様々な分野で活用されていますが、その開発には膨大なコストがかかるのが課題です。特に、携帯機器などリソースが限られた環境で実行できるモデルサイズは限定的な場合があります。

(translated with Google Gemma 3n E2B)

厳密な翻訳になっておらず指示追従性で劣る印象ですが、大意は失われていません。要約などであれば十分に使える水準ではないでしょうか。

Gemini 2.5 Proの翻訳

最後に、フラッグシップAIと比較してみましょう。

最近さ、いろんなところで「基盤モデル」ってやつが使われてるよね。超すごいスパコンみたいな環境から、手元のスマホまで、本当にいろんな場面で動いてる。でも、こういうモデルを学習させるのって、めちゃくちゃお金がかかるから、提供できるモデルのサイズの種類って、実はそんなに多くないんだ。だから、使う側としては「うーん、このモデル、うちの環境のスピードとかコストにピッタリじゃないんだけどなぁ…」ってなりがちなんだよね。

(translated with Gemini 2.5 Pro)

さすがに何枚も上手な感がありますね。じゃあ、Gemma 3nはいらないのでしょうか?

「ぜんぶGeminiでいいじゃん」とはならない、破格の性能

ネットなしで使ってましたぼくはそうは思いません。Gemma 3nはスマホで動く──つまり、ネットにつながっていないときでも使えてこの性能なのがデカすぎる。

オフラインで使える機械翻訳と比べてみよう

たとえば、ぼくは海外出張時に翻訳アプリ「Google Translate」をよく使います。海外ではネット接続が不安定なことが多いので、ネット接続不要で使えるこのアプリはとても頼もしい。

で、そのGoogle Translateで今回のさまざまなAIに訳させた文章を翻訳するとこんな感じ。

基盤モデルは、大規模なマルチアクセラレータ・クラスタからリソース制約のあるスタンドアロンのモバイルデバイスまで、推論制約の異なる幅広い環境に適用されます。しかし、これらのモデルのトレーニングには多大なコストがかかるため、提供できるモデルサイズの数が限られてしまうことがよくあります。その結果、実務者は、特定のレイテンシとコスト要件に最適ではないモデルを選択せざるを得なくなります。

(translated with Google Translate (offline))

Gemma 3nは生成AI、機械翻訳のGoogle Translateよりも圧倒的に理解しやすい文章を返せます。Gemma 3nが実用化されたら、ネットにつなげない状況でもより良質な翻訳を得られるようになるはずです。

「ネットなし」で考えるとめっちゃすごい

上掲の翻訳内にもある通り、今みんなが使っているChatGPTやGeminiのようなフラッグシップAIはネット接続必須なので、回線に問題がある場合には使えません。そして、Gemma 3nはむしろ「ネットなし」の状況で戦えるように作られているのです。

Gemma 3nは「ネットなしで実用できる、現状最高水準の性能のスマホという感触です。しかも、その性能はいろんなアプリ・状況で活用可能です(開発用の資料も公開済み)。公にできない大切な情報の処理にも使えるでしょうし、もしかしたらスマホ用のエージェントAIになってスマホをより快適に使えるようにしてくれるのかもしれません。

“普通のスマホ・PCで使えるAI”を作る技術「MatFormer2」

Gemma 3n E2B(左)とE4B(右)の動作速度。E2Bは生成中に自然に読める感じ、E4Bは「終わったら読むね」って感じのスピードです繰り返しになりますが、ChatGPTなどの広く用いられているLLMは高性能路線で、スマホでは動きません。推論時でも100B超のパラメータを丸ごと載せるため、数十GBのVRAMと高出力GPUが必須です。ネット経由で接続して使うことになります。

そんな状況の中で、Gemma 3nはMatFormer2という新技術を用いて作られ、「スマートフォンなどのコンシューマ向けデバイスで動作する」「実現可能な範囲で最高クラスの推論能力」という背反する性能を実現。Googleはブレイクスルーを起こしたように見えます。

「AIの入れ子構造」でメリットを生みまくり

Image: Google via arxivMatFormer2は「ベースとなる巨大モデルの中に小モデルを入れ子構造(マトリョーシカ構造)で作る」という技術です。Gemma 3nの2Bと4Bは、同じ大きなモデルが元になっていおり、4Bの中には2Bが内包されています。入れ子構造なのでね。

この技術には3つすごいところがあり、「何を食べたらこういうの思いつけるんだろう」ってくらい合理的です。

1. 動作スペックを抑えた“コンパクトモデル”を切り出せる。Gemma 3nはE2BとE4Bの2段階ですが、理論上はもっと細かいサイズ(L/M/Sなど)も抽出可能。一般的なノートPCに最適化されたモデルも作れそうな雰囲気です。

2. 動作の仕方も従来のモデルとは異なっていて、層・ヘッド・FFNをリクエスト時だけ選択的にロードします。その結果、必要なメモリや計算負荷が最小化されます。

3. 何より、この手法で作ったサブモデルは同じサイズを単独で学習したモデルより高精度になります。

事実、Gemma 3nはE2BもE4BもGoogle Pixel 9(2025年水準で標準的な性能のスマホ)で快適に動作しました。性能は上でご紹介したとおりです。

本当の意味での“自分専用AI”がやってくる時代が見えてきた感じ、しませんか?ChatGPTやGeminiは「みんなで使うAI」ですが、Gemma 3nは「本当にあなたのスマホの中だけで考え」ます。チューニング(LoRA)にも対応しているので、アプリとかで利用される場合は今回のテストよりも遙かにかゆいところに手が届く性能になってる可能性もあります。

試すのはめんどい。スマホへの正式版実装・活用したアプリに期待

Gemma 3nは無料で試すことができますが、スマホ上で動かすとなると手順がやや煩雑です。現状、スマホアプリ開発者向けに公開されており、一般に使う用ではない点にはご注意ください。

水鳥(アオサギ/Grey Heron)の写真を認識させてみているところ。オオアオサギ(Great Blue Heron)とまちがえていますが、よく似ている鳥なのでだいぶ惜しいです。撮影地を伏せるといういじわるをしている&説明はわかりやすくまとまっていたので、印象は悪くありません1. GitHubからGoogle AI Edge Galleryをダウンロード。APKという形式です

2. ストレージから選択、手動インストール

3. アプリを開いてモデルをダウンロード。この際、Hugging Faceのアカウントでログイン・同意書への同意が必要になります

4. ダウンロードが完了したら、あとはアプリ内でいろいろ試せます

個人的にはめちゃくちゃ感動しました。ハルシネーションは主流のAIよりも出やすいものの、プロンプトに資料を入れるなどすれば正確な出力ができる基本性能があります。画像認識にも対応しており、英語だときちんと被写体を認識・説明できたりもしました(日本語だと正答率が下がるのは悲しかった)。

各社がスマホでネイティブ動作するAIの開発を進めていましたが、本命がきた!って感じです。Gemma 3nを利用したアプリが多数出るでしょうし、Androidへの統合なども行われるのではないかと思います。

オフラインでも動く点がGeminiとの最大の差になるでしょう。Androidに統合される際は、基本ローカル推論+必要に応じてクラウド補完の「おいしいとこ取り」になってる可能性もあります。

そして、より多くの人がAIに触れやすくなるはず。生成AIにはハルシネーション・悪用される恐れがあるなど、まだまだ問題も多いですが、いい相乗効果も生まれて欲しい。

ともあれ、Gemma 3nは“この先の未来”を感じさせるAIモデルでした。AIにはまだまだ大きな進展がありそうです。

Source: Google, Google AI Edge Gallery, arxiv