生成AIは人を愚かにするだろうか。“書く”仕事、変革の現場から考える|ニュースイッチ by 日刊工業新聞社

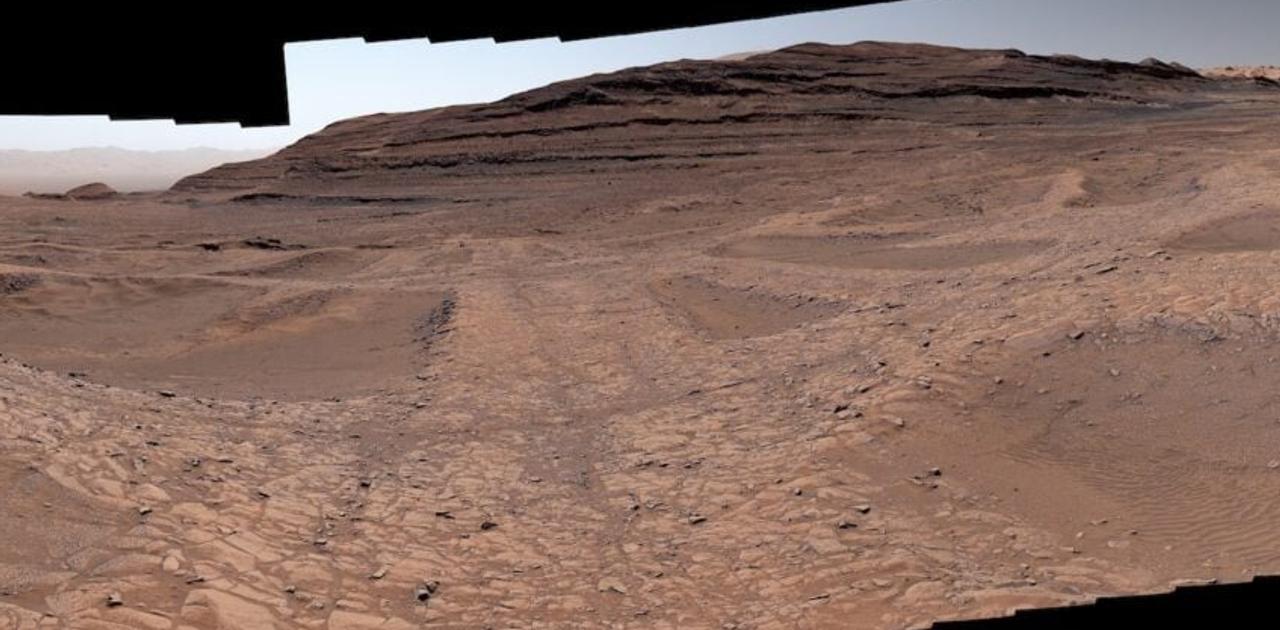

人は自分で考えて文章を書くのではなく、AIが生成したテキストを承認して責任を負うことが役割となりつつある(イメージ)

生成AI(人工知能)が“書く”仕事を変革している。専門的な原稿であってもAIが自然な文章を出力するようになった。書き手は自分で考えて書くのではなく、AIが生成したテキストを承認して責任を負うことが役割となりつつある。そしてこの流れを、AIによる支援で自信を付けた“素人上司”らが加速させている。生成AIは人を愚かにするのだろうか。この問題を解くには、人間が論理的に感じていた文章とは何だったのかを探る必要がある。(小寺貴之)

「あまり時間は残されていないかもしれない」と東京大学の影浦峡教授は指摘する。生成AIは執筆業のあり方を大きく変えた。特に英語圏での影響は甚大だ。ジャーナリストやテクニカルライター、翻訳家といったほぼすべての書き手が、業務の再構築や生存戦略の再考を求められている。

AI支援でテキストの生産性は向上するものの、文章が均質になり、AIが学習していない文化や専門性などの細かな要素が失われる点が課題だ。科学論文ではAI支援で文章構成が似通い、AIが多用する単語が急増した。文化面では学習データの少ない非西洋の文化が消えていく問題が“AI植民地主義”と批判されている。

例えば米コーネル大学の研究チームは、米国人60人とインド人60人にエッセーを書かせてAI支援の影響を検証した。書き手は予測変換のようにAIが提案する短文を見ながら執筆したところ、米国人・インド人ともにエッセーが均質化した。さらにAI支援のエッセーは米国寄りに収束していた。インド人の文章を西洋の書き方に向かわせている可能性がある。

実際にインド人が書いたエッセーからは「ラクシュミ」や「ギーマサラドーサ」などのインドの神々や料理の記述が減り、祭事が「家族が集まるお祭り」などと一般化していた。好きな食べ物にチーズが挙げられたり、インド料理の説明がエキゾチックに表現されたりするなど、西洋化のバイアス(偏り)があった。同研究チームは「文化的に偏ったコンテンツが急増しAIの次の学習データになる前に対処すべきだ」と強調している。

AIの出力は学習したデータに依存するため、デジタル化されていない文化圏や、細分化しデータ量の少ない専門分野の細かな知見が消えていくリスクがある。これを加速するのが企業などの組織にいる素人上司や、業務を発注するクライアントだ。現場感覚や専門知識がないため、生成AIの情報を疑わずに部下や受注者に指示を出す。AI支援で作文をしたり、原稿を修正したりするものの、その意図や根拠を明確に説明できない。

齟齬(そご)が見つかった場合、上司と部下ならば話し合って解決しやすい。ただクライアントとフリーランスのように力関係があると話し合いの場が設けられず、クライアントが生成AIを使っていることに気が付かない場合もある。

生成AIは誤情報を出力するハルシネーション(幻覚)が発生する。そのためハルシネーションで混入した誤情報を探して訂正し、文章に責任を持つのは人間の役割になる。この確認作業は素人にはできないため、現場や専門家にファクトチェックを要請する。この間違い探し業務は書き手にとって負荷が大きい。結局、文章を書くのと同程度の仕事量が必要になる。なぜピントのずれた修正が求められるのかがわからないまま文章を直し続け、疲弊すると徐々に文章の品質保証がされなくなっていく。

米国では編集者が専門家に依頼していた原稿をすべてAIで生成するようになった例もある。この編集者は調査に原稿の催促や締め切り管理から解放されたと回答している。さまざまな経路でハルシネーションを含む文章が広がりつつあり、東大の影浦教授は「専門家が担ってきた重要な認識スキルや基準を広く共有可能にしていく必要がある」と指摘する。

文章の「理論性」判別困難に 認知メカニズム解明課題

ここで生成AIの登場以前もテキストの品質保証は十分だったのかという疑問にぶつかる。素人が論理的に感じる文章も、専門家が読むと論理が破綻している例は多々あった。この問題がより深刻になる。生成AIのテキストは文法や流暢(りゅうちょう)さでは内容の拙さを判別できない。ハルシネーションを含むテキストが専門家名義で量産されるため、論理的な文章なのか、論理的に感じる文章なのかが、専門家であっても判別が難しくなっている。

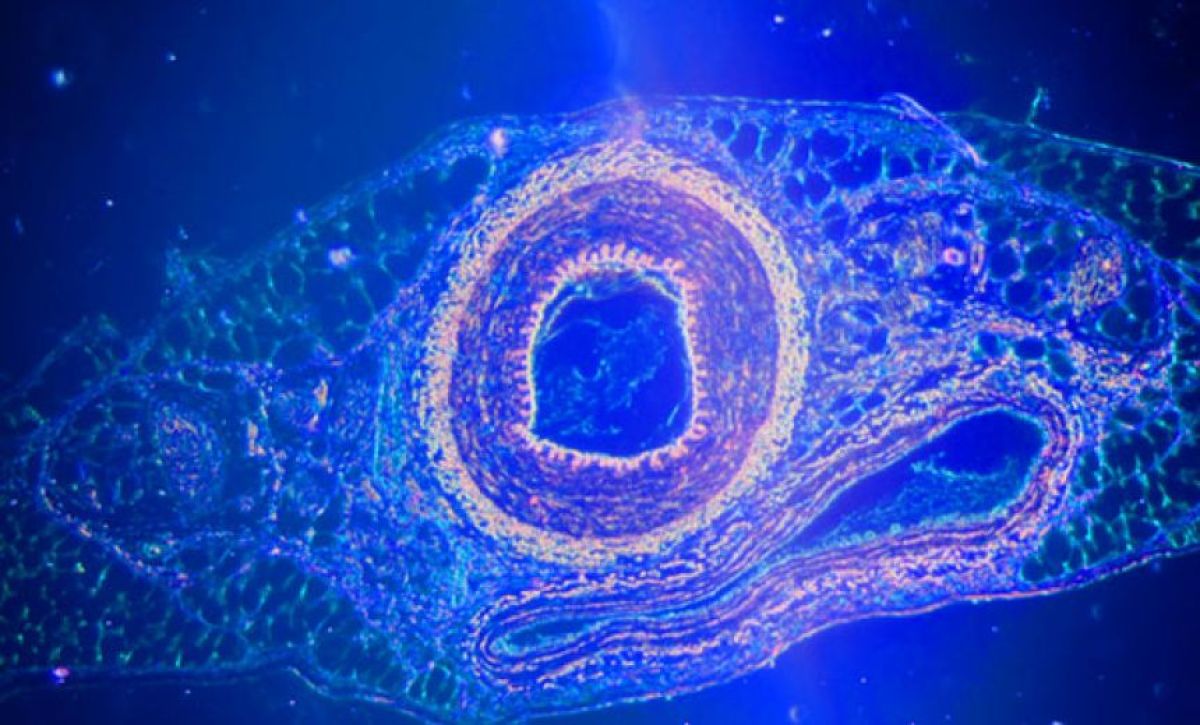

論理的な文章と論理的に感じる文章の区別がつかないまま、生成AIに慣れると人間はどうなるのだろうか。あらためて人間の認知メカニズムが注目されている。認知科学研究者らは、ヒト対ヒトで行ってきた認知心理実験をAI対ヒトで追試している。実験結果はさまざまだが、おおむねヒト対ヒトでの結果が再現されている。

例えば米マサチューセッツ工科大学の研究チームは、合成記憶を植え付けられるリスクを提起する。実験では200人の被験者が24枚の画像を記憶した後、被験者に対して生成AIで編集した画像や動画が提示される。すると誤った記憶が最大で2倍に増えた。目撃証言実験のように記憶を事後的に書き換えられる可能性を示している。

文章生成でも人間が自ら考えて書くのではなく、AIが提示する文章を追認している。与えられた文章を事後的に論理的と感じている可能性がある。

そして人間が文章を理解する認知メカニズム自体が、いまなお未解明だ。研究の進展が待たれるが、東大の影浦教授は「認知メカニズムで文章理解を解明しようというアプローチは、文章を理解すること自体を自明なものとして扱うという矛盾がある。これでは問題に気付くことさえできない」とみる。人間は自分は論理的に考えていると思いがちだが、科学者たちはその深淵を計りかねている。

解決策の模索は始まっている。東大の馬場雪乃准教授は論点整理の可視化ツールを開発した。クライアントとフリーランスの力関係のように、声の大きな意見に議論が流されないよう整理する。馬場准教授は「力関係でコミュニケーションが歪むところにこそAI技術を適用したい。相互不信が生じて集団無責任に陥るのを防ぎたい」と力を込める。

倫理学やAIアライメントを専門とする大阪大学の長門裕介講師は「テクノロジーに慣れることだけが解決策ではない。自分たちのコミュニティーは何を大切にするのかという本質を探す話し合いが大切」と語る。何を大切とするかの共有ができない状態で生成AIの活用ルールやマニュアルを整備しても表層的な対応になってしまうためだ。

AIに委ねてヒトは何を捨て、何を伸ばすのか。市場原理だけでない選択が必要だ。そして話し合いで解決するならば技術開発や業界でのルール整備は不要なため、費用対効果は高い。東大の影浦教授は「将来、誰もが直面する課題。拒絶するのではなく解決策を考えていく必要がある」と指摘する。