【笠原一輝のユビキタス情報局】王者NVIDIAのAI用GPUの強み、追い上げるAMDに足りないものとは?

先週、AI用GPU市場を巡って大きな発表があるイベントが2つ開催された。1つは「2025 OCP Summit」で、もう1つが「Oracle AI World」。前者はOCP(Open Compute Project)という業界団体が開催する、データセンター向けの機器向けのカンファレンスで、後者は4大CSP(Cloud Service Provider)の1つであるOCI(Oracle Cloud Infrastructure)に関する話題が多く語られるOracleの年次イベントになる。

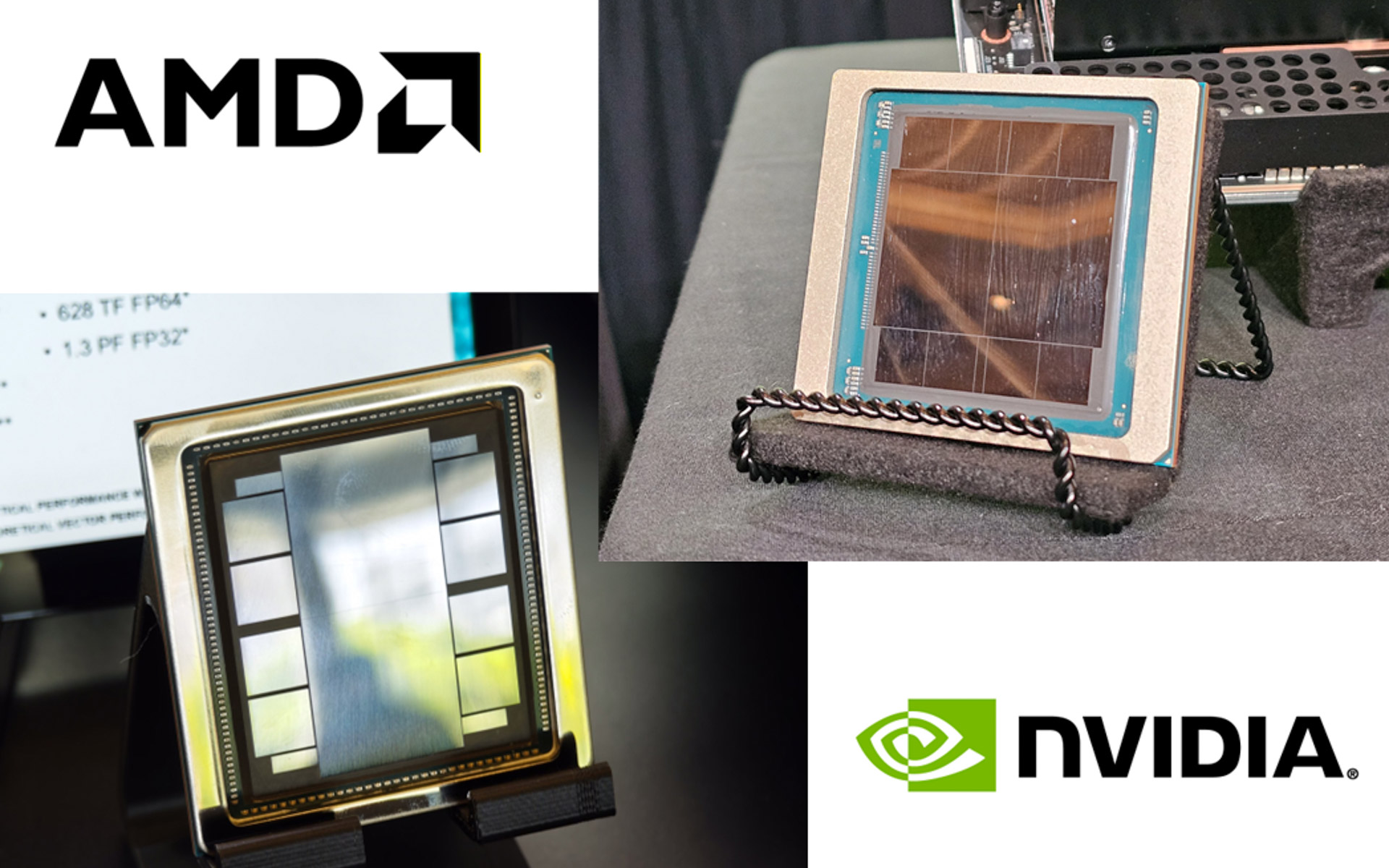

そこで注目を集めたのは、言うまでもなくAIのための演算装置であるGPUとその周辺ソリューションとなる。本記事ではOCP SummitやOracle AI Worldで発表された内容などを元に、AI演算装置では絶対王者となるNVIDIAの強み、そしてそれを追いかけるAMDの戦略などに関して説明していきたい。

NVIDIAの今の強みは「CUDA」「NVLink」「高速ネットワーク」「ラックレベルのソリューション」の4つで、AMDはこのうち3つまではすでに追いつきつつあるある状況。AMDに足りないものとは……?

2年前のCOMPUTEXだったか、NVIDIAのジェンスン・フアンCEOに、NVIDIAはAI向け半導体市場でどれくらいシェアを得ているのか?という質問が記者から飛んだことがある。フアン氏「学習に限るなら90%以上」というのがそのときの答えだった。

そこから2年は経過しており、米中の政治的な経済紛争などがあり、中国市場でシェアを落としたと思われるものの、数字は大きく変わっていないと考えられている。それだけNVIDIAの学習時のAI半導体市場の支配は揺るがない状況だ。

AI用GPUでのNVIDIAの強みとは何か?それをシンプルに表現したのは、競合であるIntelのCEO(当時)だったパット・ゲルシンガー氏の次のコメントだ。「NVIDIAの強みは3つのプロプライエタリでベンダーロックインできていることだ。1つはCUDA、2つ目がNVLink、そして事実上のプロプライエタリになっている高速ネットワークだ」。

CUDAは、NVIDIAが2006年に導入したプログラミングモデルで、プログラマーが通常使い慣れたプログラム言語(C++など)やAIフレームワーク(TensorFlowなど)を利用してコードを書き、CUDAがそれを抽象化したNVIDIA GPU上で実行するという仕組みになっている。

ここで重要なことはCUDAがGPUを抽象化しているため、プログラムから見ると、100万基のGPUから構成されるクラスタであろうが、PCのように1台のGeForceであろうが、プログラムからは1つのGPUとしてしか見えないことだ。1基からそれこそ100万基まで伸縮自在なハードウェア構成を1つのGPUとして扱い、プログラムを走らせて処理を実行できるのがCUDAを利用するメリットだ。

CUDAはNVIDIAのGPUでしか動かないようになっているし、NVIDIAのIPで保護されている。このため、IntelやArmのCPU ISA(命令セットアーキテクチャ)がそうであるように、他社が無許可で互換のGPUを作ることを防いでいる。

CUDAを利用してソフトウェアを作れば、次のハードウェアもCUDAに対応したGPU(NVIDIA)を選ばざるを得ない……この繰り返しが再生産されていくことで、NVIDIAのGPUが今やAIでは絶対王者として君臨しているのが今の状況だ。

このことは、過去にPC時代の初期にIntelのx86が、そしてスマートフォンの初期にArmに発生したことが、NVIDIAのCUDAでも起こったというのが現実で、半導体業界ではこれまでに見てきた光景が繰り返されているに過ぎないのだが……。

NVIDIAがこれだけAI向け半導体で市場を独占できたのは、CUDAの強みを生かして、さらにそれを拡張していったことにある。

その拡張部分がNVLinkと2019年に買収したMellanox Technologies(以下Mellanox)由来のInfiniBandと高速Ethernetという2種類の高速ネットワーク技術だ。

CPU/GPUをベースにしたデータセンターでは、スケールアップ(縦方向への拡大)、スケールアウト(横方向への拡大)という2つの手法でGPUの数が増やされている。スケールアップというのは、主にサーバー機器の内部やそのサーバー機器が格納されるラックの内部でCPUやGPUを増やしていく手法になる。

それに対してスケールアウトは、そのラックとラックをつないでラックの数を増やしていくことでCPUやGPUを増やしていく手法となる。

一般的にスケールアップ時には、CPUの内部バスと同じようなハイスピードのインターコネクトを利用し、スケールアウト時には高速なネットワークを利用して接続していく。

NVIDIAがスケールアップに利用しているのがNVLinkだ。NVLinkはもともと、NVIDIAのGPU同士を接続するインターコネクトとして開発され、後にNVLink Switchというスイッチチップが登場したことで、より多くのGPUの性能を落とすことなく接続可能になった。

現在のNVIDIA GPU(Blackwell)に採用されているのが第5世代のNVLinkで、1,800GB/sという帯域幅を実現している。NVIDIAは以前の世代から、NVLinkとNVLink Switchを利用してGPUを8基で1つの4Uサーバー機器にしている「DGX」や「HGX」を提供してきた。

さらに、現在のBlackwell世代では、NVLink Switchと組み合わせることで、GB200(2x Blackwell GPU、1x Grace CPU)を利用してGPUを最大72基まで対応可能なラック(GB200 NVL72、開発コードネーム: Oberon)のデザインが可能になっている。

そうしたGB200 NVL72のラックを、スケールアウト(横方向に拡張)するのに利用されるのが、InfiniBandや高速Ethernetなどの超高速ネットワークだ。

NVIDIAはこの超高速ネットワークのソリューションを、2019年にイスラエルのMellanox社を買収したときに得た製品をベースに拡張中。InfiniBandが「Quantum」、Ethernetが「Spectrum/Connect」で、そこまで大規模ではないシステム向けのDPU「BlueField」などの製品をラインナップして提供している。

InfiniBandの最新製品である「Quantum-X800」、Ethernetの最新製品である「ConnectX-8」はいずれも800Gbpsというハイスピードを実現している。NVIDIAの強みはそうしたアダプタだけでなく、アダプタやNICなどを使ってスイッチ製品を構築しており、それも合わせて提供していることになる。

つまり、NVIDIAはGPU単体だけでなく、それが8基で1つのサーバーとなるDGXやHGX、さらにスケールアップしたラックレベルのGB200 NVL72、そして最終的にInfiniBandやEthernetで数千~数十万にスケールアウトするというソリューションを統合的に提供できているのだ。これがNVIDIAの強みになっている。

だが、ここ最近のNVIDIAからの新しい発表を見る限り、そのNVIDIAの3つの強み(CUDA、NVLink、高速ネットワーク)にさらにもう1つの強みを入れたほうが良さそうだ。それがラックなどデータセンターの物理的な設計だ。

NVIDIAは、2024年のGTCにおいて開発コードネーム「Oberon」で知られるラックデザインを発表している。

Oberonは、NVIDIAが開発したラックのリファレンスデザインで、GB200(Grace CPU×1、Blackwell GPU×2)をサーバー機器内に2つ実装し、それを18枚格納することで、1ラックで32基のGrace CPUと72基のBlackwell GPUというCPU、GPUにスケールアップできるようにしている。

NVIDIAが今年3月のGTC 2025で発表した計画では、来年投入される次世代のVera Rubin(Vera CPUとRubin GPUが1ボードに載る製品)を採用することで、Vera Rubin NVL144というラックデザインが実現可能になる。最大144基のRubin GPUを構成でき、最大3.6EFLOPS(FP4/推論)/1.2EFLOPS(FP8学習)を1ラックだけで実現可能になる。

今回、NVIDIAが2025 OCP Summitにおいて発表したのは、その次世代のラックとなるKyberを実現する要素技術。Kyberでは最大587基のRubin Ultra GPUを1ラックで実現すると説明しており、単純計算でVera Rubin NVL144の約4倍の密度を実現する見通しだ。

そのKyberを実現する技術として「800VDC 電力供給、液冷、機械設計」をKyber世代で導入することを、NVIDIAは2025 OCP Summitにおいて発表した。

一般的な北米のデータセンターでは「415VAC(415Vの交流)」ないしは「480VAC(480Vの交流) 三相システム」という電力をPDU(Power Distribution Unit)を利用して208VAC(208Vの交流)や120VAC(120Vの交流)などに変換してシステムに電源を供給している。

さらに、その供給された電力が機器のPSU(Power Supply Unit)で54VDC(54Vの直流)に変換され、さらに基板上のVRM(Voltage Regulator Module)でCPUやGPUなどが必要とする電圧になって供給されている(一般的なデスクトップPCの仕組みと基本的には同じだ)。

NVIDIAによれば800VDC(800Vの直流)では、その名の通り800Vの直流の電力をデータセンターに、次にラックに直接供給し、それを機器の中で54VDCに変換していく。これにより交流から直流に、あるいは電圧変換で発生する無駄な電力の消費がなくなり、データセンター全体の効率が上がる仕組みだ。

こうした新しい技術を導入することで、NVIDIAはスケールアップとスケールアウトで実現できるGPUの数をさらに増やしていくことになる。

実際、Oracle AI Worldでは、OracleはNVIDIAのGPU(どの世代のGPUかは明らかにされていないが、時期的にはRubin世代だと考えられる)を使用して最大80万基を接続した「Zettascale 10 SuperCluster」を2026年の後半に実現すると明らかにした。Oracleによれば16Z(ゼタ)FLOPS以上の性能を実現し、実に1.5GWの消費電力を消費するという。

なお、OracleはAMDのInstinct MI455Xを搭載した大規模クラスタの構想も同時に明らかにしているが、そちらは同じ2026年というタイミングで最大5万基と発表されている。大規模な80万基のGPUからなるスーパークラスタを構築できるNVIDIAと、そこに到達できていないAMDというコントラストが明確になった瞬間だ。これが今の時点でのNVIDIAとAMDの現実だ。

ただ、AMDはかなり現実的にNVIDIAに追いつこうとしている。ステップバイステップで、NVIDIAの強みを1つ1つ消している。それ故に、現状NVIDIAのGPUからほかのAI半導体に移ることを検討している企業が、一番最初の選択肢として挙げるのはAMDのInstinctシリーズだ。

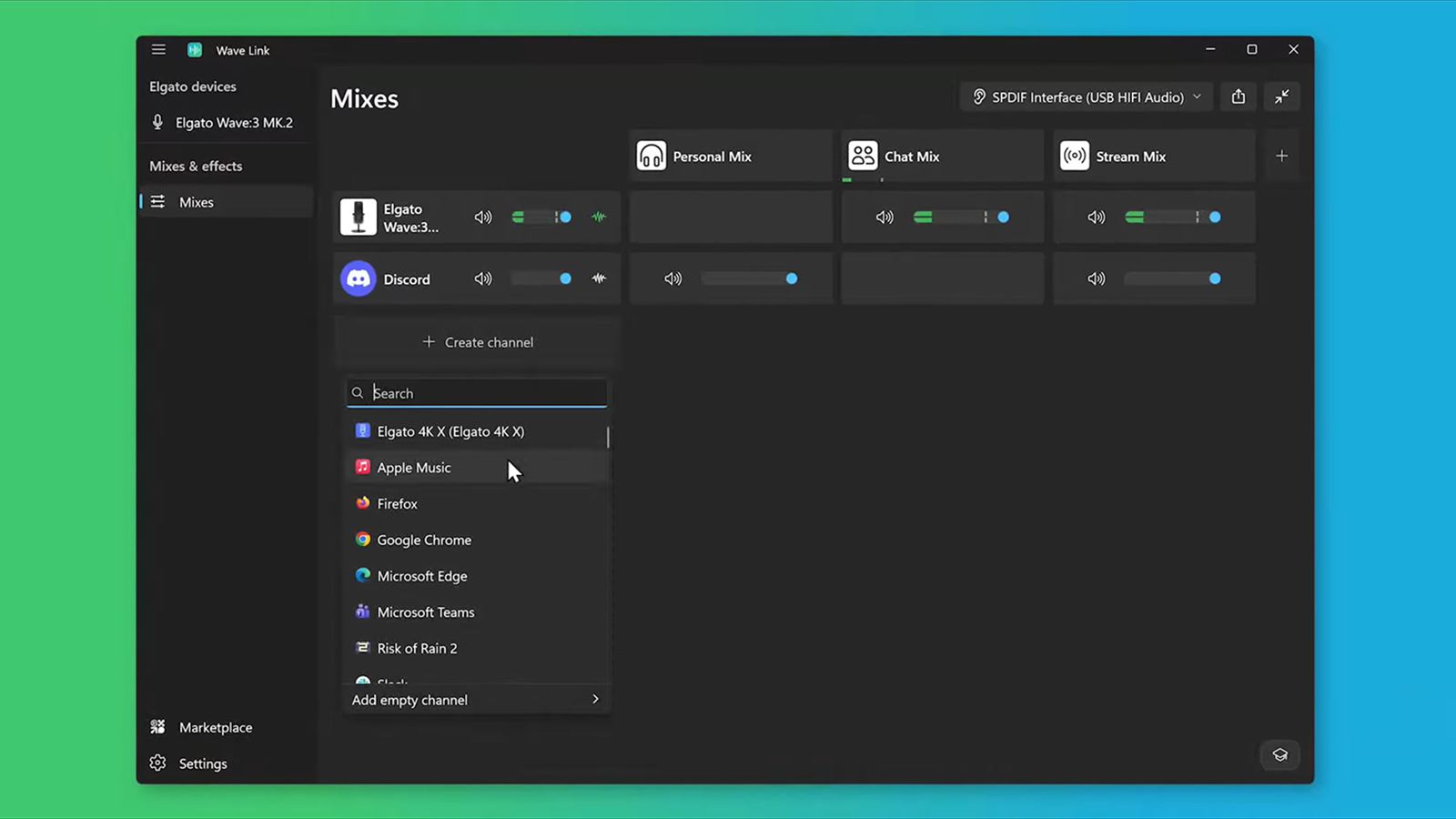

最初にリリースされたのが2023年に発表された「Instinct MI300X」で、AMDのGPGPUソフトウェア開発環境だったROCmとHIPCC(Heterogeneous-Compute Interface for Portability Clang Compiler)の組み合わせで、AIソフトウェア開発環境を提供している。

NVIDIAのCUDAで言えば、CUDAそのものがHIPCCで、CUDA-Xに相当する開発キットがROCmとなる。AI開発者はROCmを利用することで、TensorFlowなどのAIフレームワークを利用しながらAMDのGPUで実行できる(つまりHIPCC向けの)コードを生成し、すでにCUDA向けのコードを持っている場合にはHIPCC向けのコードに変換可能。これにより、従来CUDAで開発していたAIソフトウェアのコードをAMDの環境にインポートできる。こうしたソリューションによりNVIDIAと同じような環境をすでに用意している。

なお、このタイミングでは同時にMI300AというEPYC CPUとGPUが1パッケージにされたものが登場したが、この世代限りで後継製品は発表されていない。

2024年に発表されたのが「Instinct MI325X」となる。GPUの基本的な構造は同じで、DRAMがHBM3からHBM3eに強化され、容量が192GBから256GBに強化され、結果メモリ帯域は5.3TB/sから6TB/sに強化された製品だ。

そして、今年の6月に発表されたのがInstinct MI355Xで、内部のアーキテクチャがCDNA 4に強化され、内部アーキテクチャの改良による性能の改善分が上乗せされている。

このように、3世代順調に進化してきたAMDのAI向けGPUだが、次の大きなジャンプになると考えられているのが、今年の6月のイベントで来年AMDが導入すると明らかにした「Instinct MI455X」だ。

Instinct MI455Xで、AMDは「Helios」という開発コードネームを与えられたラックデザインを提供する。要するにNVIDIAの「Oberon」や「Kyber」に対抗するようなラックのリファレンスデザインをAMDも提供するということだ。

また、AMDは今年6月に開催されたイベントの中で、同社が業界他社と取り組んでいる「Fast Ethernet」に準拠したNICとして「Vulcano」の計画を発表。現行製品の400Gbpsの倍の転送速度となる800Gbpsに達し、ネットワークソリューションでもNVIDIAに追い付くことを目指している。

AMDは最近2つの大きなデザインウインを獲得している。1つはOpenAIとの提携で、最大6GWまでのGPUを導入し、それを実現するのと引き換えにOpenAIがAMDの新株予約権を得る契約だ。

また、Oracleのイベントで、OracleはAMDのMI355Xを採用したインスタンスの一般提供開始を明らかにし、同時にMI455Xを採用したインスタンスを来年以降に提供する計画であることを明らかにしている。

このことは、OpenAIのようなAIモデル開発企業、OracleのようなCSPにとっては、NVIDIAのほかの選択肢として、AMDのポジションが増していることを意味し、NVIDIAよりもローコストで同じ性能を提供できることがアドバンテージになりつつある。

このようにAMDは、ゲルシンガー氏がNVIDIAの強みとして指摘した「CUDA、NVLink、高速なネットワーク」、そして筆者の指摘した「データセンター向けのラックデザイン」のうち3つ(CUDA、高速ネットワーク、ラックデザイン)までをカバーしたことになる。

しかし、NVLinkへの対抗は?という疑問が出てくるだろう。

AMDはNVLinkへの対抗策として、Intelなどの競合他社も含めた業界団体(UALink Consortium)が策定したUALink(Ultra Accelerator Link)を2024年に発表し、競合他社を含めて強く採用を呼びかけている。

UALinkの規格は、そもそもAMDが自社のGPUやCPU間のインターコネクトとして利用していた「Infinity Fabric」をAMDがUALink Consortiumに寄贈したものがベースになっている(UALink自体はオープンな規格となっており、物理層の上で動かすプロトコルはさまざまな選択肢がある)。

すでに「UALink 200G 1.0 Specification」がすでに一般公開されており、規格としては利用できるようになっているが、現時点ではまだ採用されている製品がない状況だ。旗振り役であるAMDは?と言えば、AMDはHeliosでUALinkに対応すると明らかにしたが、MI455XがUALinkに対応しているかどうかに関しては一言も言及していない。

AMDの執行役員兼データセンターGPU事業本部事業本部長であるアンドリュー・ディックマン氏は「HeliosのラックでUALinkに対応する計画で、最初の実装はUALinkでEthernetプロトコルのトンネリングを行なう計画だ。我々は100%UALinkにコミットしており、スイッチチップを製造するパートナーと協力して開発を進めつつ、将来もっと多くを発表することが可能になるだろう」と述べている。

ラックを実現する技術としてUALinkには対応するものの、NVLinkのようなスケールアップ時に利用するのではなく、最初はネットワーク実装の一部として利用する計画で、同時に将来の製品でUALinkのフル実装を行なうことを示唆している。

これはどういうことかというと、おそらくMI455XにはUALinkのコントローラは実装されていないか、あるいは実装されていても、スイッチチップなどパートナー側の開発が遅れており、スケールアップ用としては活用できないのだろう。

そのため、NVIDIAとのスケールアップ競争の性能競争では引き続き厳しい状況が続くことになる。同じ2026年にOracleが導入する予定の、AMDのInstinct MI455Xベースのクラスタが5万基までしかスケールアップ/スケールアウトできず、NVIDIA GPUベースのクラスタは80万基までスケールアップ/スケールアウトできるのはこれが理由の1つだと考えられる。

このように、UALinkに関してAMDはやや足踏みしているという印象が拭えない状況だが、その間にNVIDIAのほうは前に進んでしまっている。6月のCOMPUTEX 2025でジェンスン・フアンCEOが発表した「NVLink Fusion」がそれだ。

NVLink Fusionは、これまで門外不出だったNVLinkを半オープン化するもので、NVIDIAのGPUないしはCPUと接続する場合に限るという前提条件の下で、競合の半導体メーカーにNVLinkのライセンスを付与するプログラムだ。

このCOMPUTEXのタイミングでは、富士通とQualcommがArm CPUを開発するパートナーとして発表され、さらにその後の9月にはIntelがNVIDIAのGPU向けに、NVLinkをサポートしたカスタムのx86 CPUを設計、製造して供給することが明らかにされている。

このように、AMDが足踏みしている間に、UALinkに加盟していた富士通、Qualcomm、そしてUALink ConsortiumのプロモーターメンバーでもあるIntelがNVLink側に行ってしまったというのが現実だ。

つまりNVIDIAは半分だけでもNVLinkをオープンにするだけで、オープンを旗頭にしてきたUALinkの芽を摘むことに成功したというわけだ。その意味で、特に同じx86 CPU陣営だったIntelがNVLink側に行ってしまったことはAMDにとって悪夢だと言えるだろう。

ただ、上のレポートで富士通が答えているように、NVLink Fusionへの対応は、UALinkへの対応をやめるわけではないというのがCPUベンダー側の姿勢だ。その意味では、富士通、Qualcomm、IntelがNVLink FusionとUALinkの両対応にする可能性はあり、そこはAMDにとっては救いになるだろう。

しかし、明らかにAMDに残された時間は少なく、いかに迅速にUALinkを発展させていけるか、そこがAMDのAI GPU事業にとってNVIDIAを追いかける鍵となるはずだ。