「生成AIは巨大なコピー機」という主張は正しいのか? AIが“著作権コンテンツ”をどれくらい再現できるのか検証(生成AIクローズアップ)

1週間の気になる生成AI技術・研究をいくつかピックアップして解説する連載「生成AIウィークリー」から、特に興味深いAI技術や研究にスポットライトを当てる生成AIクローズアップ。

今回は、大規模言語モデル(LLM)が著作権のある書籍をどの程度記憶し、再現できるかを定量的に検証した研究「Extracting memorized pieces of (copyrighted) books from open-weight language models」を取り上げます。

先日、ディズニーとユニバーサルが画像生成AIでお馴染みの「Midjourney」を著作権侵害で訴えたニュースが世界中で報道されました。このようなAI企業と著作権を保持する企業との関係は明確ではなく、これから法整備がされていくと考えられます。それにあたり、厳密性が問われます。

今回取り上げる研究では、著作権のある文章を学習しているLLMにおいて、その状態で同じ文章をどれだけ出力できるのかを調べた内容になります。これにより、どれだけ再現できたら違反などの目安を獲得しやすくなると考えられます。

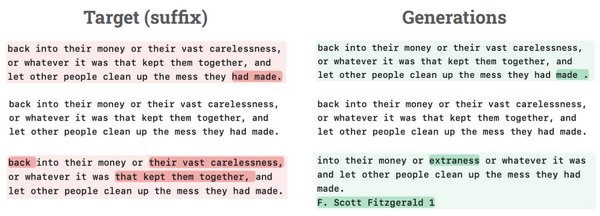

▲左が元の文章で、右がAIで生成した文章

米スタンフォード大学や米コーネル工科大学などによる研究チームは、約20万冊の書籍を含む海賊版コーパス「Books3データセット」で訓練された13種類のオープンウェイトLLMを対象に、確率的抽出手法を用いて記憶されたテキストの抽出を試みました。従来の「抽出できた・できなかった」という二値的評価ではなく、特定のテキストが生成される確率を定量的に測定するアプローチを採用しています。

実験結果は予想以上に複雑な様相を呈しました。注目すべきは、Llama 3.1 70Bモデルが「ハリー・ポッターと賢者の石」や「1984年」などの著名作品をほぼ完全に記憶していたことです。適切なプロンプトを与えることで、「ハリー・ポッター」の91%以上の部分から元のテキストを正確に抽出できることが判明しました。

しかし、この現象は全ての書籍に当てはまるわけではありません。テストされた56冊の書籍の大部分では記憶の程度は低く、例えば著作権訴訟の原告であるリチャード・カドレーの「サンドマン・スリム」では、同じLlama 3.1 70Bモデルでも高確率で抽出できる部分はほとんど存在しませんでした。

Books3テキストの抽出率

▲「ハリー・ポッター」と「サンドマン・スリム」の書籍全体のうちどれくらい抽出できるかをモデル別で比較した図

記憶の程度は、モデルのサイズだけでなく、書籍の人気度や訓練データ内での重複の程度にも影響されます。一般的に人気のある書籍は、インターネット上の様々な場所で引用されたり議論されたりするため、結果的により多く記憶される傾向があります。また、同じLlamaファミリーのモデルでも、世代が新しいほど記憶率が高いという傾向も観察されました。

この研究結果は、進行中もしくはこれからの著作権訴訟に重要な示唆を与えます。原告側の「LLMは巨大なコピー機械である」という主張も、被告側の「LLMは統計的相関を学習するだけで複製はしていない」という主張も、どちらも実態を正確に反映していません。

特に深刻なのは、オープンウェイトモデルの配布問題です。HuggingFaceでのLlama 3.1 70Bのダウンロード数が月間10万回を超えることを考慮すると、仮にモデルが著作権侵害と認定された場合、潜在的な損害賠償額は膨大になる可能性があります。

仮にLlama 3.1 70Bのダウンロード数がトータルで100万回だとすると、「ハリー・ポッターと賢者の石」、そして著作権で保護されている他の書籍で、僅少を超える量の著作物表現が記憶されているものについて、潜在的に侵害となる複製物の100万回の配布と見なされる可能性があります。侵害著作物1件あたり15万ドルとすると、たとえBooks3の3%がモデル内の侵害複製物と判断されたとしても、潜在的な法定損害賠償額は10億ドル近くになります。

ただし、記憶されたテキストの抽出には技術的な困難が伴います。研究で使用された抽出手法では、わずか50トークンのテキストを抽出するのに数千回から数百万回の試行が必要となる場合があります。

本研究は、LLMにおける著作権問題が従来想定されていたよりもはるかに複雑であることを示しています。特定のモデルと特定の書籍の組み合わせでは相当量の記憶化が確認される一方、大半の書籍は全体的にも部分的にもほとんど記憶されていません。この不均一性は、集団訴訟としての扱いを困難にし、ケースバイケースでの判断が必要となることを示唆しています。